Documentation

De Dbpedia.fr.

Sommaire |

Processus d'extraction des données de Wikipédia

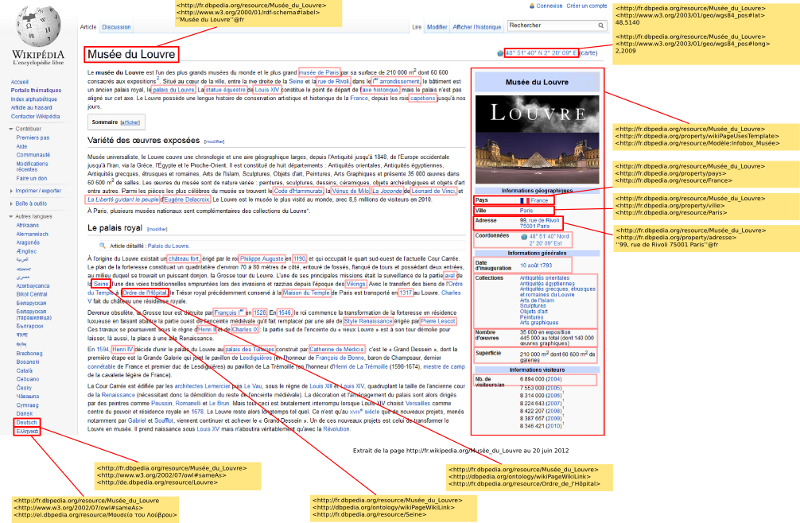

Chaque page de Wikipédia est parcourue par un ensemble d'extracteurs. Chaque extracteur identifie un élément de la page et génère des données en fonction de son contenu.

Par exemple, la figure suivante présente les données extraites à partir de différents éléments de la page du Musée du Louvre.

Les données générées sont des triplets RDF (format standard du W3C pour la représentation des données).

La liste des extracteurs est donnée sur cette page, la page correspondante à chacun des extracteurs décrit les données générées.

La page Extraction du 27 Aout 2013 donne le volume des dernières données générées.

Les outils d'extraction sont maintenus par la communauté DBpedia, la documentation originale est accessible à cette adresse : http://wiki.dbpedia.org/Documentation. Une version traduite est disponible ici: Installation_des_outils_d'extraction.

Outils d'extraction

La documentation technique des outils d'extraction est fournie sur le site de dbpedia.org : http://wiki.dbpedia.org/Documentation.

Quelques pages en français :

Accès aux données

Téléchargement des données

Les "dumps", c'est-à-dire les fichiers contenant l'ensemble des données générées pour une image de Wikipédia à un instant donné, peuvent être téléchargés à cette adresse : http://fr.dbpedia.org/download/ .

Accès par déréférencement

Suivant les principes de Linked Data, les ressources sont identifiées par des URIs déréférençables, c'est-à-dire qu'elles sont accessibles par http.

Requêtes SPARQL

SPARQL est un language de requêtes sur des données RDF défini par le W3C, voir les exemples de requêtes SPARQL.

Un service SPARQL est accessible à l'adresse http://fr.dbpedia.org/sparql. Une interface html permet d'exécuter des requêtes directement. Il est aussi possible d'effectuer les requêtes par GET/POST en passant la requête en paramètre "query".

Installation et configuration d'un serveur Virtuoso

L'installation et la configuration d'un serveur Virtuoso pour servir les données extraites sont détaillées dans les pages suivantes :

- Installation de Virtuoso

- Configuration de Virtuoso pour DBpedia

- Chargement des données dans Virtuoso

Utilisation de MediaWiki

Création d'un miroir de Wikipédia

Actuellement, l'extraction des résumés d'articles se fait par appel à l'API de mediawiki. Afin de ne pas surcharger le site fr.wikipedia.org, il faut installer un miroir local. Il faut installer un mediawiki en local et y charger les dumps XML téléchargés sur http://dumps.wikimedia.org/frwiki/. Cette étape est documentée sur la page de mediawiki.

Des notes d'installation sont disponibles en français à la page Chargement des dumps dans MediaWiki.

- Dernière modification de cette page le 7 juin 2013 à 10:03.

- Cette page a été consultée 5 718 fois.